動作捕捉系統用于準確測量運動物體在三維空間中的運動狀態與空間位置。ErgoLAB Motion是的全新可穿戴運動捕捉與人機工效/生物力學分析系統,配備可穿戴人因記錄儀,便于攜帶,非常適用于各種虛擬現實應用與實時的現場人因工效科學研究,如安全生產、人機交互、運動分析,動作姿勢傷害評估等。

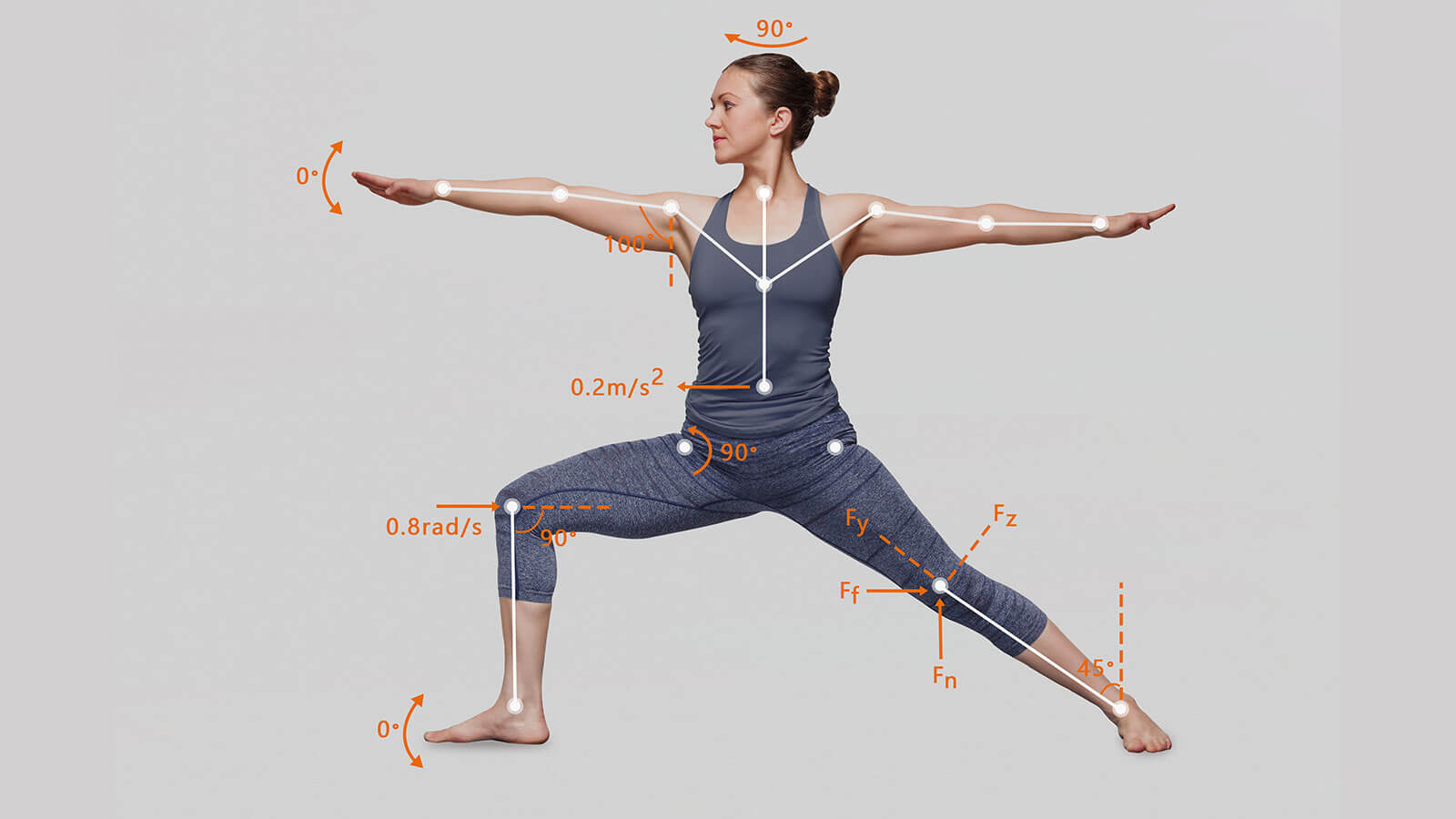

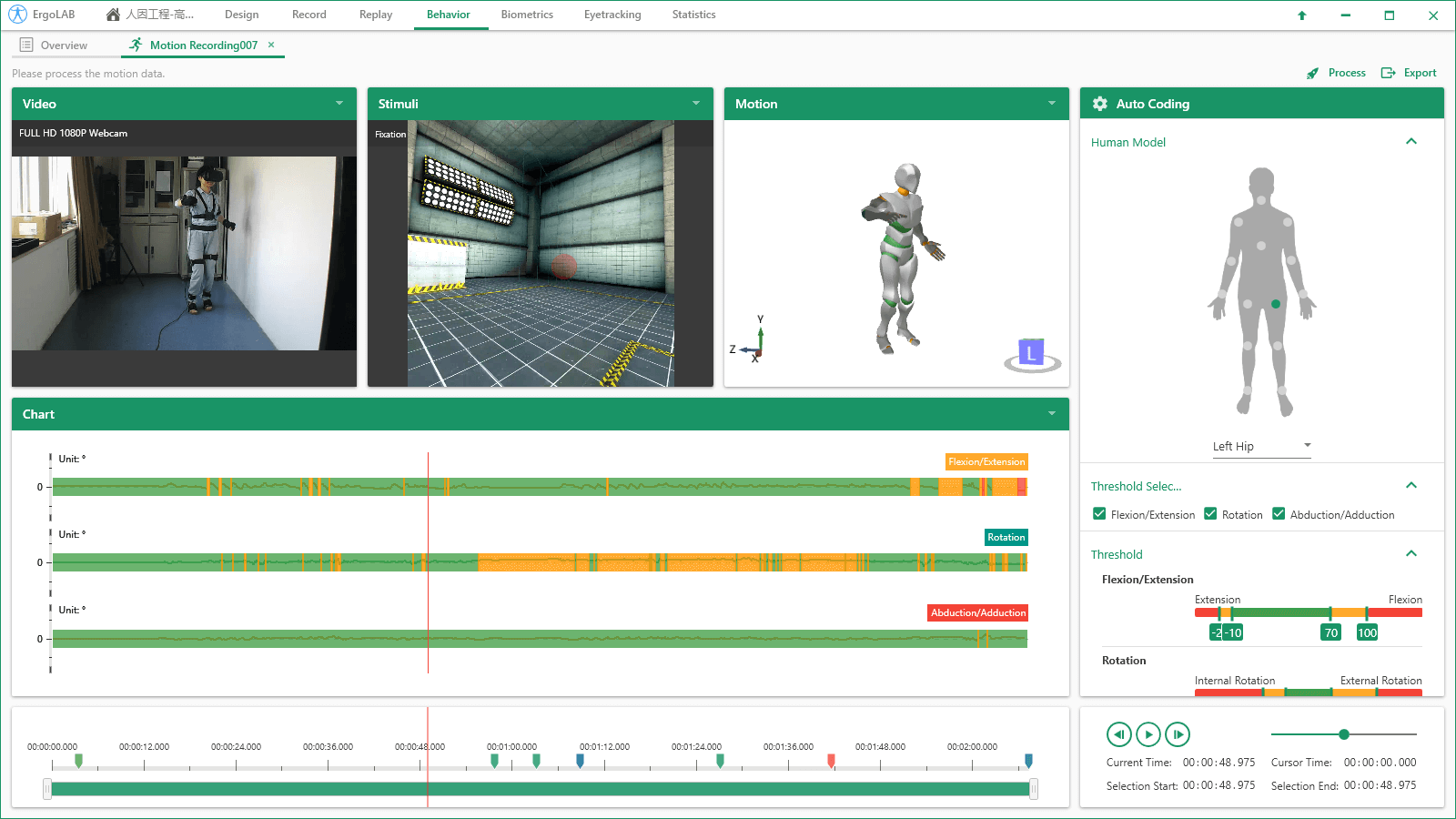

結合加速度、陀螺儀、方位傳感器實時采集人體動作,位置,速度,關節角度,扭矩等信息不受環境、光線與空間距離的限制,配備無線人因記錄儀便于攜帶,適合真實戶外現場研究抗電磁干擾能力、支持多人同時進行且數據穩定性的慣性IMU技術同時追蹤操作人員的位置、距離和步數,無需額外標記即實現較為精準的空間定位效果工效分析與姿勢傷害評估:通過3D數字人實現對動作和姿勢的實時風險評估與預警支持實時同步采集多模態數據,包括眼動、腦電、生理、行為等,支持3D空間位置計算數據采集與可視化分析

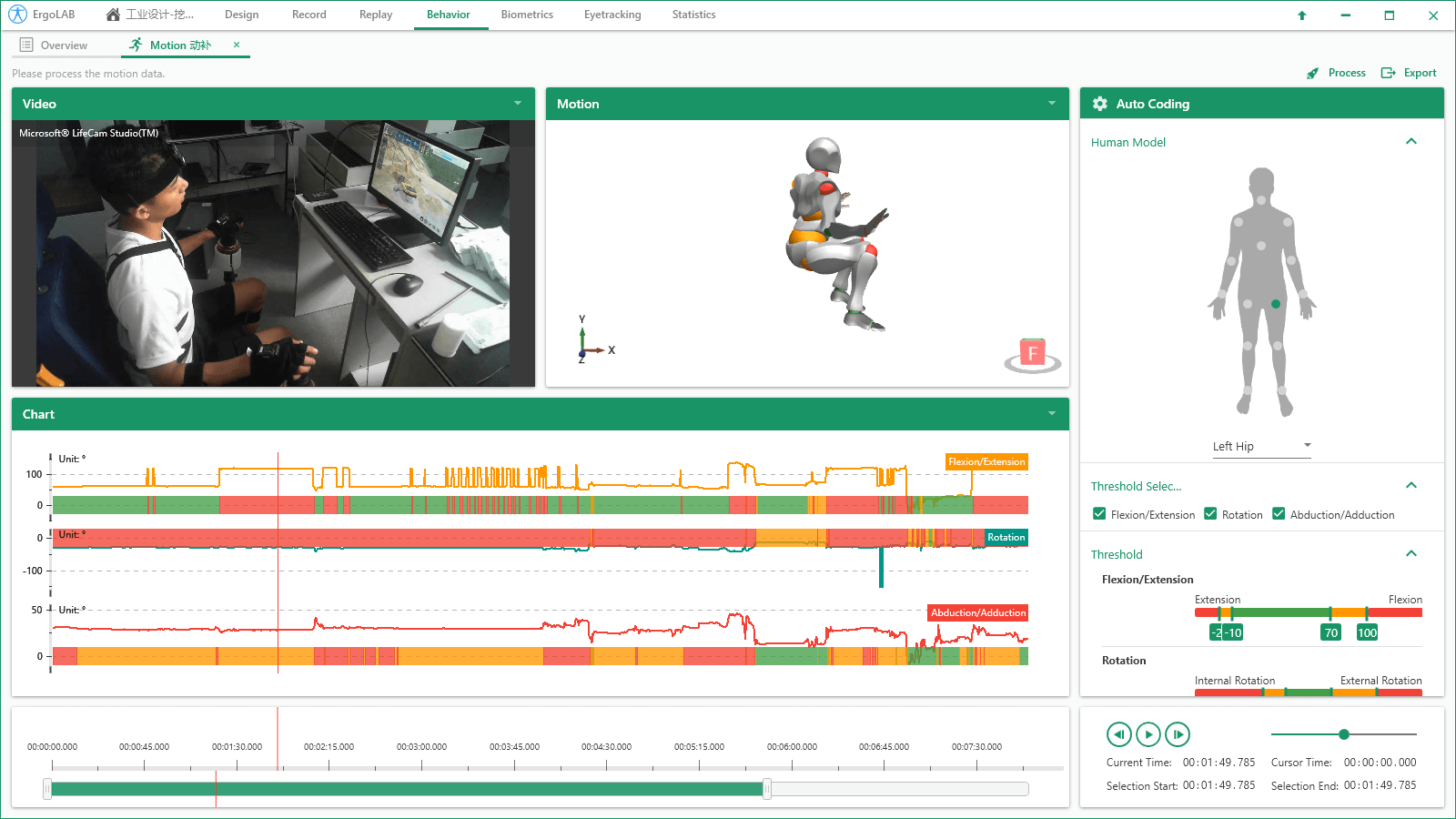

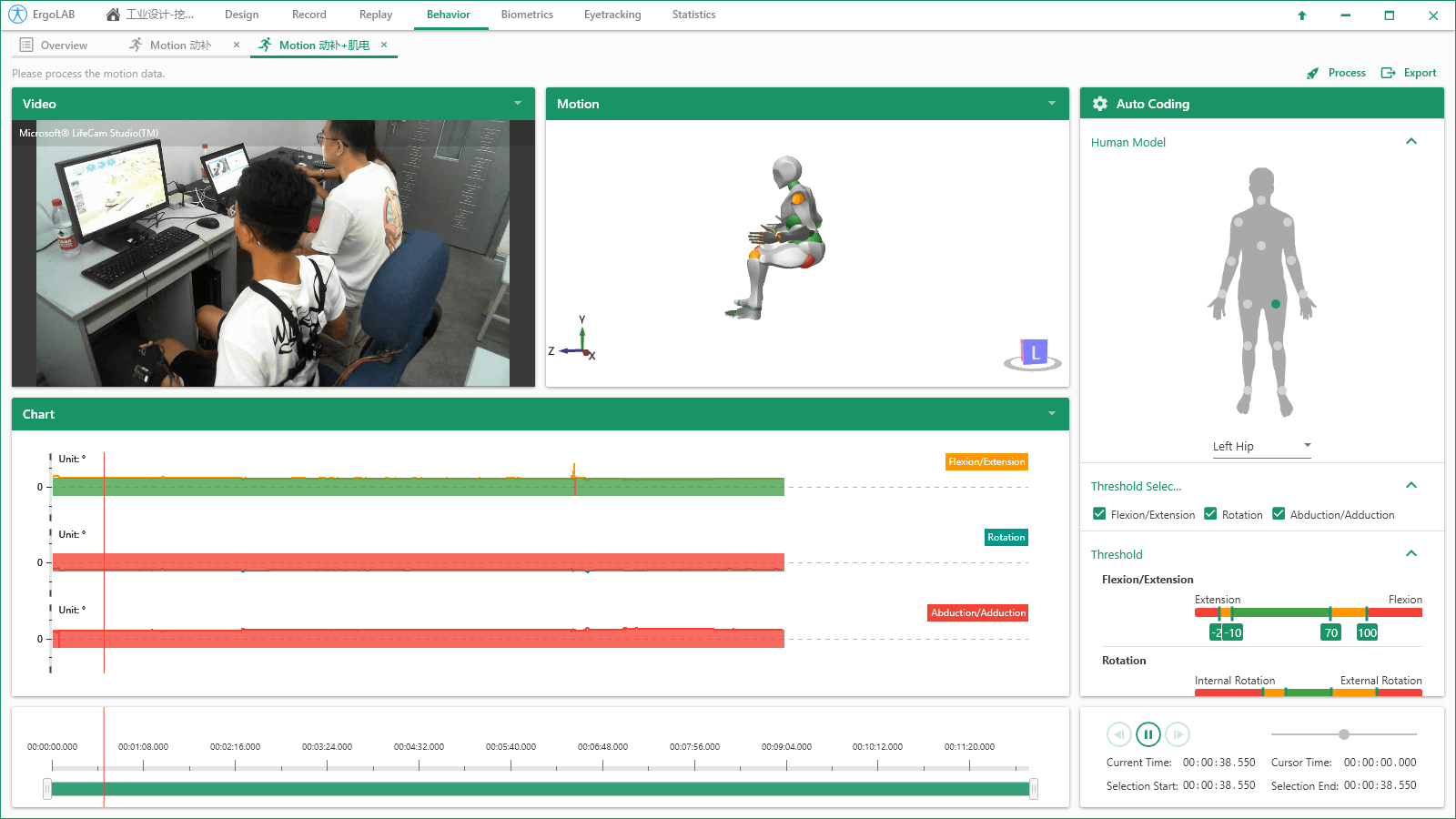

多種數據采集與編碼方式:支持實時數據傳輸以及Motion Datalog便攜式數據采集儀采集,數據可后期導入系統中,與其他多元數據同步分析。支持實時姿態編碼與后期手動編碼。自定義處理參數:可以自定義設置身高數據,并包含完整的參數處理模塊,如數據降噪、合并最短行為、自定義行為長度等,幫助用戶可以找到目標動作與動作分類。可視化3D人體模型:通過動作捕捉傳感器IMU中的加速度、磁力計、陀螺儀數據,計算人體動作,位置,速度,關節角度,扭矩等信息,精確重塑個體的3D人體動作模型,實時或離線觀察個體的運動姿態以及不同關節的運動情況。可視化數據編碼:系統默認14個關節角度的安全度閾值范圍,并自動識別并編碼個體在動態作業過程中的實時關節角度數據,并進入行為數據統計分析。動作行為數據交互分析

基礎行為分析:計算統計每種動作行為狀態發生的開始時間、結束時間、行為發生的持續時間、發生的次數、整個實驗任務中的操作安全程度比例等數據統計。交互行為分析:自動識別兩種或多種動作發生的交互關系,針對兩種或多種行為同時發生的時間、次數、概率等數據指標進行統計。行為順序效應分析:自動可視化分析一種動作發生在另一種動作之后/之前的動態關系,包括動作之間的延遲效應、順序效應分析,并一鍵導出行為發生的可視化序列性分析報告。動作姿勢傷害評估

通過3D人體數據模型,實時監測14個關節位置分別對應的Flexion / Extension彎曲/伸展; Abduction / Adduction外展/內收;Rotation旋轉以及 Angular Velocity角速度與 Angular Acceleration角加速度等,可實現對被試動作和姿勢的實時視覺反饋以及風險姿勢預警。依據職業工效學理論數據庫常模,將人體姿態的各個關節角度閾值劃分為健康(綠色)、警戒(紅色)和中等(橘色)狀態。系統可以自動化評估作業中影響工作效率的因素或可能造成職業傷害的動作。多維度數據統計與二次開發

多維度數據交叉統計:系統支持動作捕捉數據與其他多模態數據(眼動、腦電、生理、行為、面部表情等)的同步交叉分析,多個數據源在同一平臺界面呈現,在采集的同時間軸數據里選擇相應的時間片段,可同步觀察和統計分析所有數據流之間的相關關系。具有API開發接口:動作捕捉原始數據可以被其他程序實時訪問,可使其它程序對被試者的各個關節9軸姿態進行計算與加工。ErgoLAB人機環境同步云平臺可人-機-環境多維度數據的同步采集與綜合分析,包括眼動追蹤、生理測量、生物力學、腦電、腦成像、行為、人機交互、動作姿態、面部表情、主觀評 價、時空行為、模擬器、物理環境等,為科學研究及應用提供完整的數據指標。平臺可完成完整的實驗和測評流程,包括項目管理-試驗設計-同步采集-信號處理-數據分析-人工智能應用-可視化報告,支持基于云架構技術的團體測試和大數據云管理。

北京市海淀區安寧莊后街12號院1號樓一層、三層

北京市海淀區安寧莊后街12號院1號樓一層、三層 sales@kingfar.cn

sales@kingfar.cn

在線客服

在線客服